“僅憑聲音或視頻內(nèi)容即可確認(rèn)對方真實身份?”

P圖容易,模仿口音難,只要口音是本人,就應(yīng)該是本人。

流言分析

這種說法已不符合當(dāng)下科技發(fā)展情況。

目前 AI 語音合成、克隆技術(shù)已成熟,幾秒語音即可生成高仿真音色,甚至還能實現(xiàn)接近實時交流的效果。因此,“眼見已然難為實,耳聽也有可能虛”,為避免上當(dāng),需通過音畫同步、對口型細(xì)節(jié)、二次驗證等方法防范,避免輕信聲音或視頻內(nèi)容。

很多動作片或科幻片,都出現(xiàn)過特工模仿反派語音,欺騙敵人勝利完成任務(wù)的情節(jié),而今天這已成為現(xiàn)實(只不過是反的……)——騙子開始用這類技術(shù)來騙錢了!

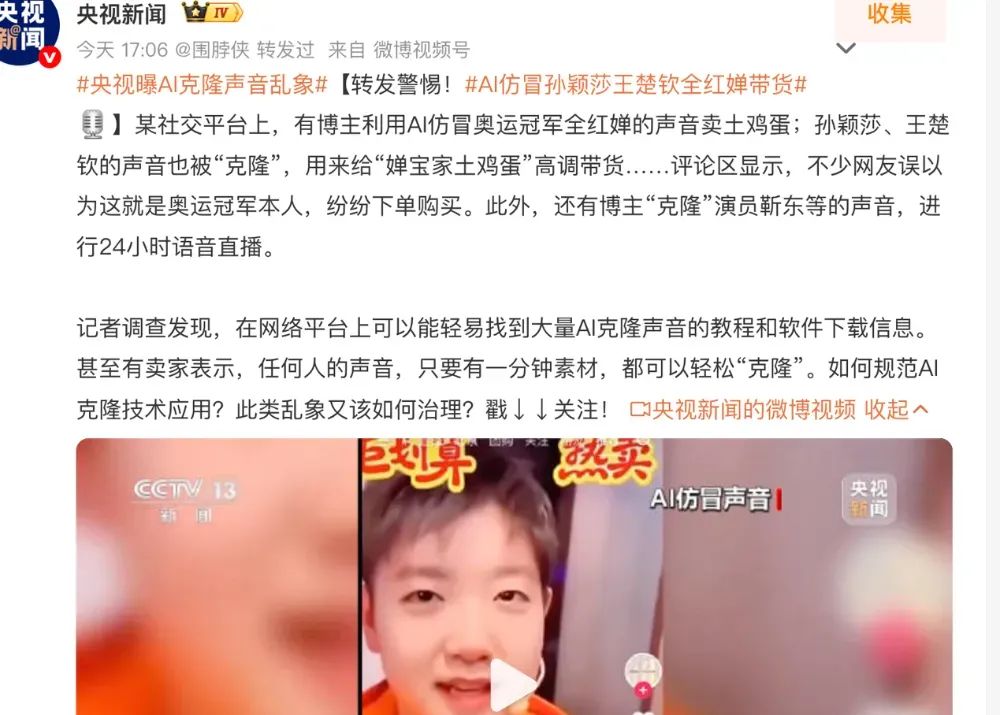

比如央視新聞前幾天這幾個案例,就讓人非常不安。

截自央視新聞

除了假裝“奧運(yùn)冠軍”帶貨,還有人做了個“馬斯克”要帶你一起投資,走上人生巔峰。

截自短視頻平臺

近兩年來,各種利用 AI 技術(shù)進(jìn)行名人明星仿冒和聲音克隆的詐騙案例,冒出一波又一波。那么這是怎么做到的,我們又該如何防范呢?今天就來聊一聊(文末有防騙指南)。

合成語音對 AI 不是難事

自 2022 年 ChatGPT 發(fā)布后,AI 才開始慢慢走進(jìn)大眾的生活,它既給我們的生活帶來很多方便,在心懷叵測的人的手中,又會帶來潛在的風(fēng)險和負(fù)面影響。現(xiàn)實就是,雖然目前的 AI 還遠(yuǎn)遠(yuǎn)不能像很多人擔(dān)心的那樣,給人類帶來滅頂之災(zāi),但它卻已經(jīng)能能輕而易舉地欺騙人類了。其中,語音識別、語音合成和語音克隆,就是一個典型方向。

最近兩年以來,聲音克隆的技術(shù)模型經(jīng)過多方、多次迭代升級,在部分開源模型中,幾秒鐘語音就能生成高度相似的音色,再利用文本轉(zhuǎn)語音技術(shù),就可以通過文本朗讀,任意編造“某個人”說話的內(nèi)容。

而名人明星們,他們有大量的聲音、視頻片段內(nèi)容,流傳在網(wǎng)絡(luò),而越大量的訓(xùn)練素材,意味著 AI 克隆出的仿真程度越高。老百姓們面對出假“全紅嬋”、假“孫穎莎”,很難不中招。

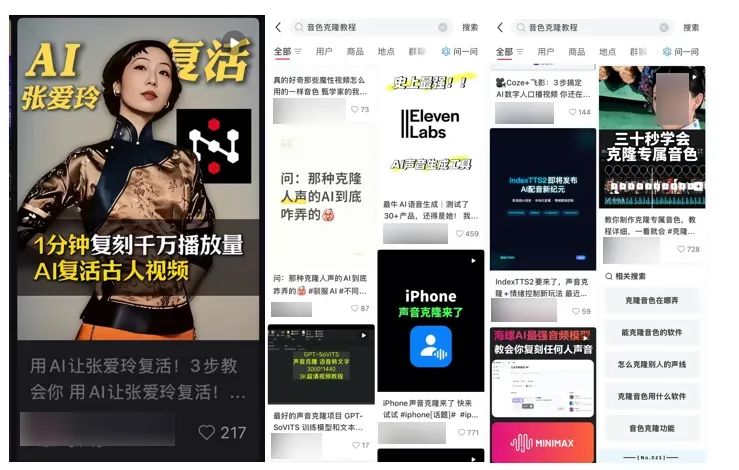

更重要的是,這些技術(shù)模型很大一部分是開源的,雖然這方便了技術(shù)交流促進(jìn)了技術(shù)進(jìn)步,但這也意味著“作案工具”唾手可得了。在此基礎(chǔ)上,已經(jīng)有了各種可以直接使用的剪輯 APP、網(wǎng)站應(yīng)用,某些教程甚至宣稱“30 秒學(xué)會”。

截自社交媒體平臺

這樣就極大地降低了使用門檻和成本,使得造假合成的音頻視頻普及度日益提升。

為什么聲音克隆仿真度

可以這么高?

那么,為什么聲音能被模仿得如此逼真呢?(如對技術(shù)內(nèi)容不感興趣可以直接拉到底看最后的防騙指南)。高中物理課上教過,咱們說話的聲音本質(zhì)上是一種時序信號,或者說是空氣分子震動產(chǎn)生的波。

你可以簡單理解成,每個人的聲音都可以分解為不同頻率波的疊加,這些頻率分布特征就是聲紋的重要基礎(chǔ)。

被麥克風(fēng)采樣,輸入后,聲音變成一串離散數(shù)據(jù)點(diǎn)(時間序列):x(t)→[x1,x2,x3,…,xn]

每個點(diǎn)就是某一時刻空氣壓力的數(shù)值,形成波形。聲音的這種數(shù)學(xué)上的一維結(jié)構(gòu)非常直觀,也為算法處理提供了很多便利性。

你可以把它想象成一條連續(xù)的曲線,許多經(jīng)典的信號處理技術(shù),如傅里葉變換(Fourier Transform),能夠非常高效地將這個時域信號分解成不同頻率的正弦波和余弦波的疊加。這等于將聲音的“配方”給解構(gòu)了出來,讓算法能清晰地“看到”聲音的頻率組成(音高、音色等),這是聲音分析一個巨大的優(yōu)勢。

相比而言 ,圖像和文本的數(shù)學(xué)化更偏向“抽象”,更復(fù)雜,影響因素更多元。比如圖像,雖然像素值本身是數(shù)字,但要理解“這是一只貓”,算法需要從像素矩陣中學(xué)習(xí)和抽象出邊緣、角點(diǎn)、紋理,再到“貓的耳朵”、“貓的眼睛”等更高層次的概念。這個過程是層層抽象的。而文本的抽象就更加極致。算法必須從零開始學(xué)習(xí)整個語言體系中符號(詞語)所代表的復(fù)雜含義和它們之間的關(guān)系。而且,和復(fù)雜的人臉相比,聲音變化維度有限(主要是頻率、音高、節(jié)奏),模型更容易捕捉到核心特征。

重中之重,提高警惕

從前文大家可以看到,聲音克隆技術(shù)既成熟又容易獲得,這也意味著我們更容易遇到這類騙局。善良的朋友們,一定能夠要提高警惕,下面就教大家一些辨別的方法。

看音畫同步:如果一個視頻,背景聲音聽起來像是“某個人”的講話,但畫面完全不同步,或者沒有這個人的正臉,嘴巴沒有跟著動,那咱們要警惕是否是語音合成,或者移花接木。

對口型細(xì)節(jié):就算有某個人正臉講話的視頻,還需要觀察口型細(xì)節(jié)是否自然。因為目前還有種視頻生成技術(shù)叫“對口型”,它可以讓人的口型根據(jù)所配的音頻內(nèi)容“動”起來,而這項技術(shù)也在不斷強(qiáng)化。所以,咱們還是要注意查看賬號屬性:是否是名人認(rèn)證賬號,是否是平臺認(rèn)證的可靠媒體。以及視頻節(jié)目是否標(biāo)注了“疑似使用 AI 技術(shù)”。

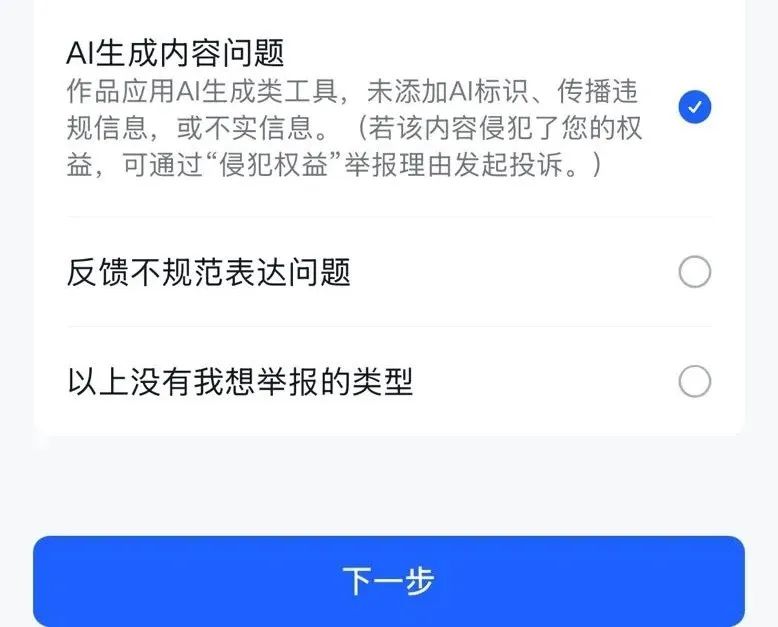

如果確定或懷疑該視頻是 AI 合成,而沒有標(biāo)注的話,可以向平臺舉報。

約二次驗證:警惕“家人”來電或語音要求轉(zhuǎn)賬,更不要輕信陌生來電。

我們可以人肉設(shè)置“語音安全碼”——比如和家人約定提問暗號來驗證身份,就像有些網(wǎng)絡(luò)支付或登錄需要“二次驗證”,咱們也要給自己的重要信息通訊加一把“鎖”。

在 AI 能克隆任何人聲音甚至偽造視頻的時代,碰到涉及到我們財產(chǎn)安全、情感寄托、或者日常消費(fèi)的決策,一定要擦亮雙眼, 看到“震驚體”的新聞或名人發(fā)言,先讓消息“飛一會兒”,冷靜觀察下視頻或內(nèi)容是否涉及 AI 合成。碰到疑似 AI 內(nèi)容而未加標(biāo)注的內(nèi)容,一定要向平臺舉報,以免假消息發(fā)酵擴(kuò)散,使得網(wǎng)絡(luò)環(huán)境污染擴(kuò)大,影響我們正常的信息攝入。

照“謠”鏡

AI 走進(jìn)大眾生活以來,確實有一些人在利用 AI 作惡。但 AI 不是洪水猛獸,它的本質(zhì)是一種工具。歷史上,每一波技術(shù)革命——從蒸汽機(jī)到電力,再到互聯(lián)網(wǎng)——都曾引發(fā)恐慌,也都伴隨騙局與濫用。但最終,社會靠制度建設(shè)、科技進(jìn)步和大眾教育,大家總能找到與新工具相處的方式。 聲音克隆只是一個縮影,它提醒我們:技術(shù)的發(fā)展,有時候會超過監(jiān)管的進(jìn)步,而每個人都必須學(xué)會在不確定中保護(hù)自己。

原標(biāo)題:僅憑聲音或視頻就能確認(rèn)對方的真實身份?千萬別被騙了!

來源:科學(xué)辟謠

初審:劉晗

復(fù)審:馬萍

終審:張宇